Datenschutz und Datenverarbeitung

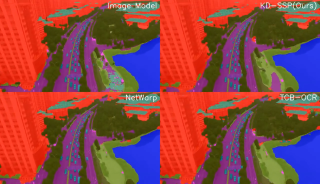

Wir setzen zum Einbinden von Videos den Anbieter YouTube ein. Wie die meisten Websites verwendet YouTube Cookies, um Informationen über die Besucher ihrer Internetseite zu sammeln. Wenn Sie das Video starten, könnte dies Datenverarbeitungsvorgänge auslösen. Darauf haben wir keinen Einfluss. Weitere Informationen über Datenschutz bei YouTube finden Sie in deren Datenschutzerklärung unter: https://policies.google.com/privacySemantic Similarity Propagation im Vergleich mit anderen Verfahren zur Videosegmentierung: deutlich höhere zeitliche Stabilität und Qualität der Segmentierung.

Um autonomes Fliegen zu ermöglichen, müssen Luftfahrtsysteme ihr Umfeld erkennen und die Objekte darin kontinuierlich in Echtzeit klassifizieren. Dabei kommen verschiedenste Sensoren zum Einsatz – unter anderem auch RGB-Kameras. Deren heterogenes Datenmaterial muss zuverlässig ausgewertet und für die autonome Flugführung zur Verfügung gestellt werden. Dank KI-gestützter semantischer Segmentierung ist das System in der Lage, die Umgebung in verständliche Kategorien zu unterteilen – wie z. B. Straßen, Gebäude, Vegetation oder Hindernisse – und so fundierte Entscheidungen zu treffen, etwa bei der Hindernisvermeidung, Notlandung oder Inspektion kritischer Infrastrukturen wie Stromleitungen. Doch bei wechselnden Lichtverhältnissen, schnellen Bewegungen oder wenigen verfügbaren Trainingsdaten schwankt die Qualität der Auswertung stark.

Ein neues Verfahren mit dem Namen Semantic Similarity Propagation (SSP) verspricht nun Abhilfe: Die Methode sorgt dafür, dass die »Verständnisleistung« der KI über mehrere Videoframes hinweg stabil bleibt – selbst bei stark bewegten Kameras. Das Verfahren wurde von Forschenden des Fraunhofer-Anwendungszentrums »Vernetzte Mobilität und Infrastruktur« und dem Institut Polytechnique de Paris entwickelt und auf der IEEE Conference on Computer Vision and Pattern Recognition (CVPR) vom 11. bis 15. Juni 2025 in Nashville, USA vorgestellt.